|

|

对抗攻防学习

深度神经网络目前已经获得了突破式发展,并且在多个领域得到了广泛应用。

然而,深度神经网络同样面临着被攻击的威胁,也就是“对抗样本”:

攻击者通过在源数据上增加难以通过感官辨识到的细微改变,让神经网络模型做出错误的分类决定。

本团队通过研究对抗样本的生成原理和算法实现,有助于分析基于深度学习的系统存在的安全漏洞,

并针对此类攻击建立更好的防范机制,加速机器学习领域的进步。

相关链接:

1. FaceBook AI:对抗攻防学习研究、

鲁棒性分析

2. 对抗攻防学习综艺节目:《燃烧吧!天才程序员》

|

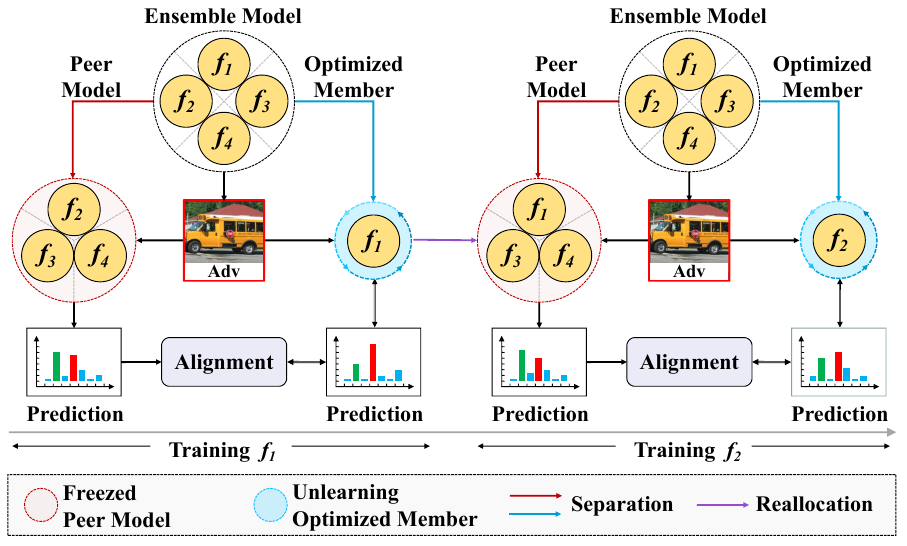

AUTE: Peer-Alignment and Self-Unlearning Boost Adversarial Robustness for Training Ensemble Models

Lifeng Huang, Tian Su, Chengying Gao, Ning Liu, Qiong Huang*

|

|

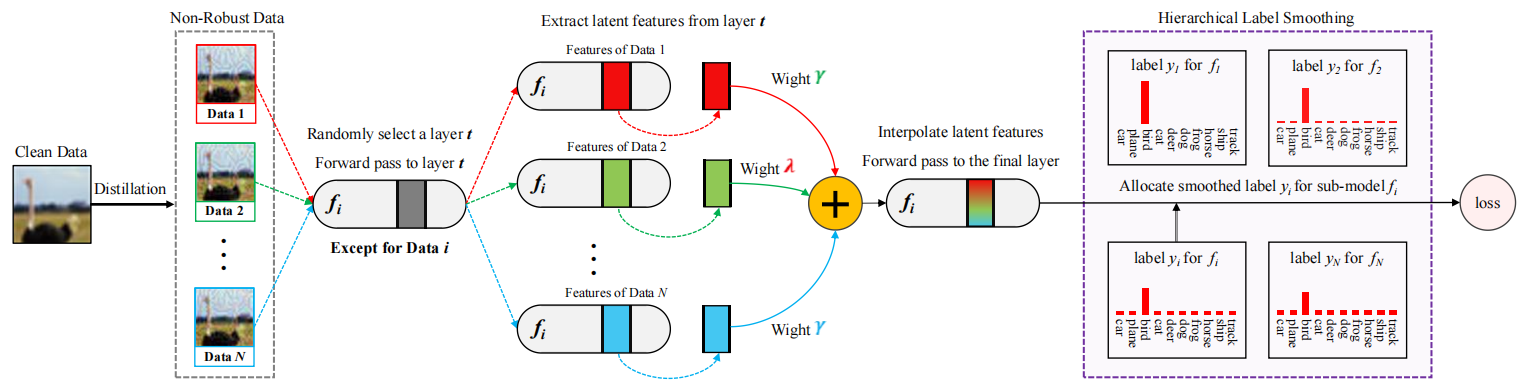

LAFED: Towards Robust Ensemble Models Via Latent Feature Diversification

Wenzi Zhuang, Lifeng Huang, Chengying Gao, Ning Liu*

|

|

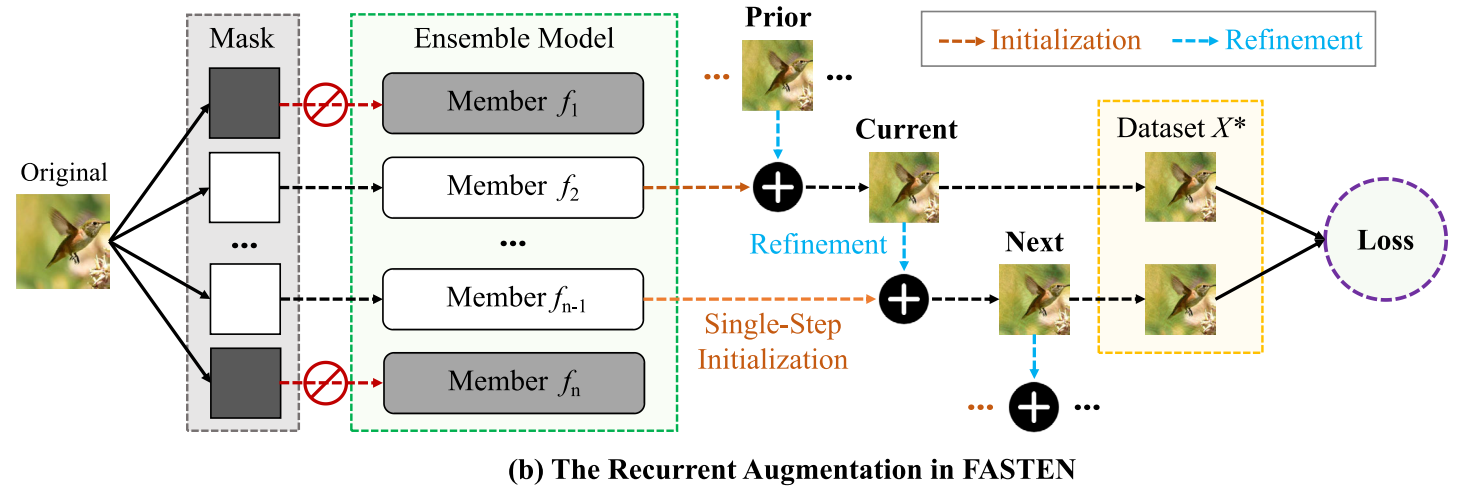

FASTEN: Fast Ensemble Learning For Improved Adversarial Robustness

Lifeng Huang, Qiong Huang, Peichao Qiu, Shuxin Wei, Chengying Gao*

|

|

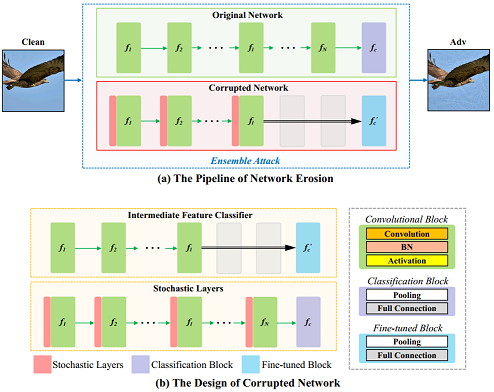

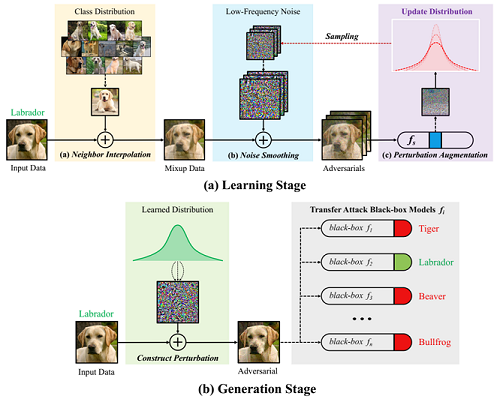

Erosion Attack: Harnessing Corruption To Improve Adversarial Examples

Lifeng Huang, Chengying Gao*, Ning Liu

|

|

DEFEAT: Decoupled Feature Attack Across Deep Neural Networks

Lifeng Huang, Chengying Gao, Ning Liu

|

|

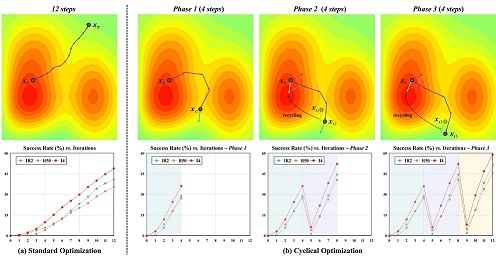

Cyclical Adversarial Attack Pierces Black-box Deep Neural Networks

Lifeng Huang, Shuxin Wei, Chengying Gao, Ning Liu

|

|

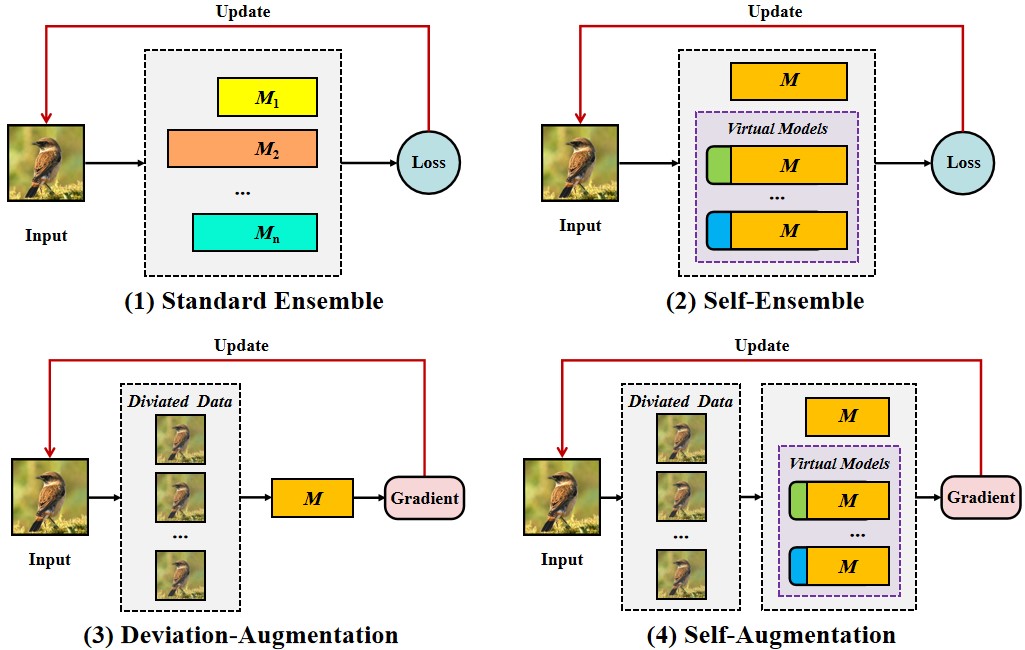

Enhancing Adversarial Examples Via Self-Augmentation

Lifeng Huang, Wenzi Zhuang, Chengying Gao, Ning Liu

|

|

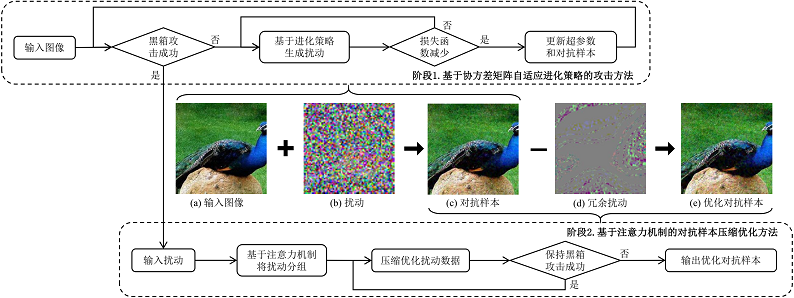

一种基于进化策略和注意力机制的黑盒对抗攻击算法

黄立峰,庄文梓,廖泳贤,刘宁

|

|

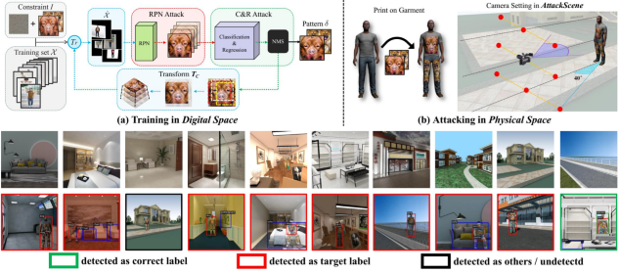

Universal Physical Camouflage Attacks on Object Detectors

Lifeng Huang, Chengying Gao, Yuyin Zhou, Changqing Zou, Cihang Xie, Alan Yuille, Ning Liu

|

|

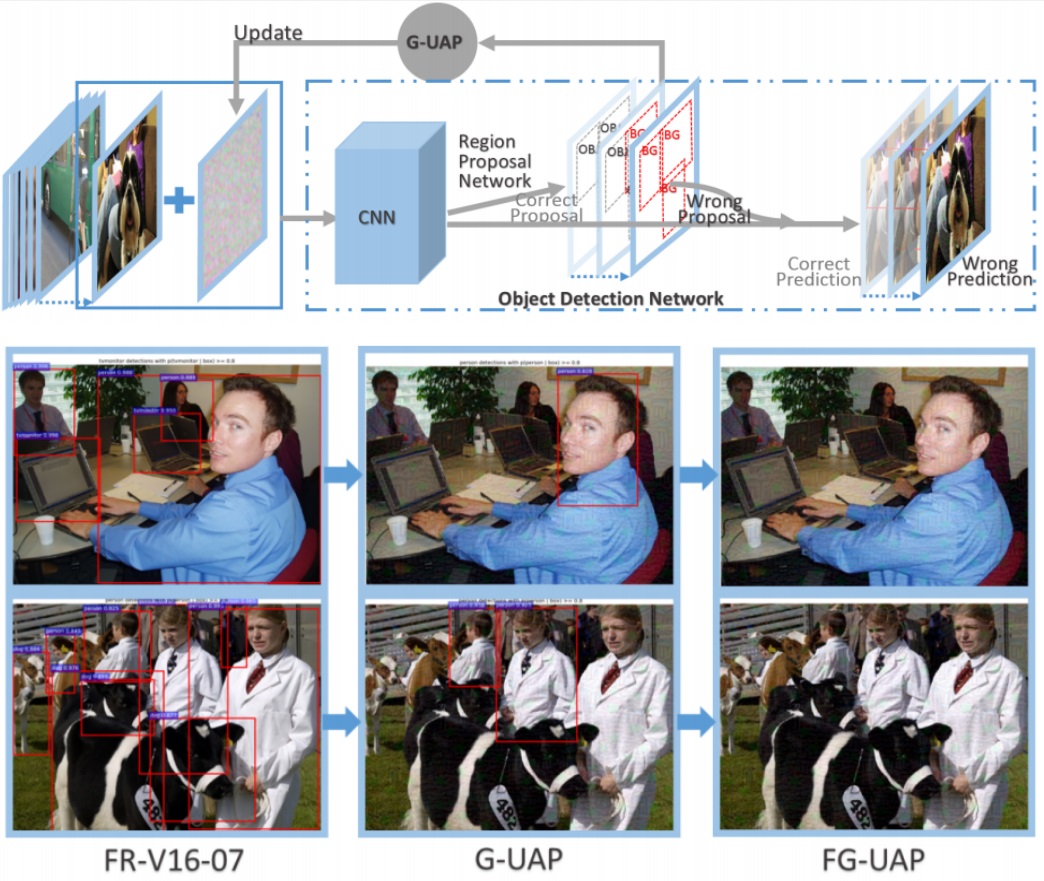

G-UAP: Generic Universal Adversarial Perturbation that Fools RPN-based Detectors

Xing wu, Lifeng Huang, Chengying Gao*

|

人群计数

行人检测与属性分析通过视频分析,实现对监控区域中的人群人数分布、人群外观属性、行人运动轨迹进行精确分析,

该研究在安防监控、自动驾驶及线下商业领域具有重要的意义。

相关链接:

1. 香港城市大学 人群计数研究:资料1、

资料2

|

Scale-aware Progressive Optimization Network

Ying Chen, Lifeng Huang, Chengying Gao, Ning Liu

|

|

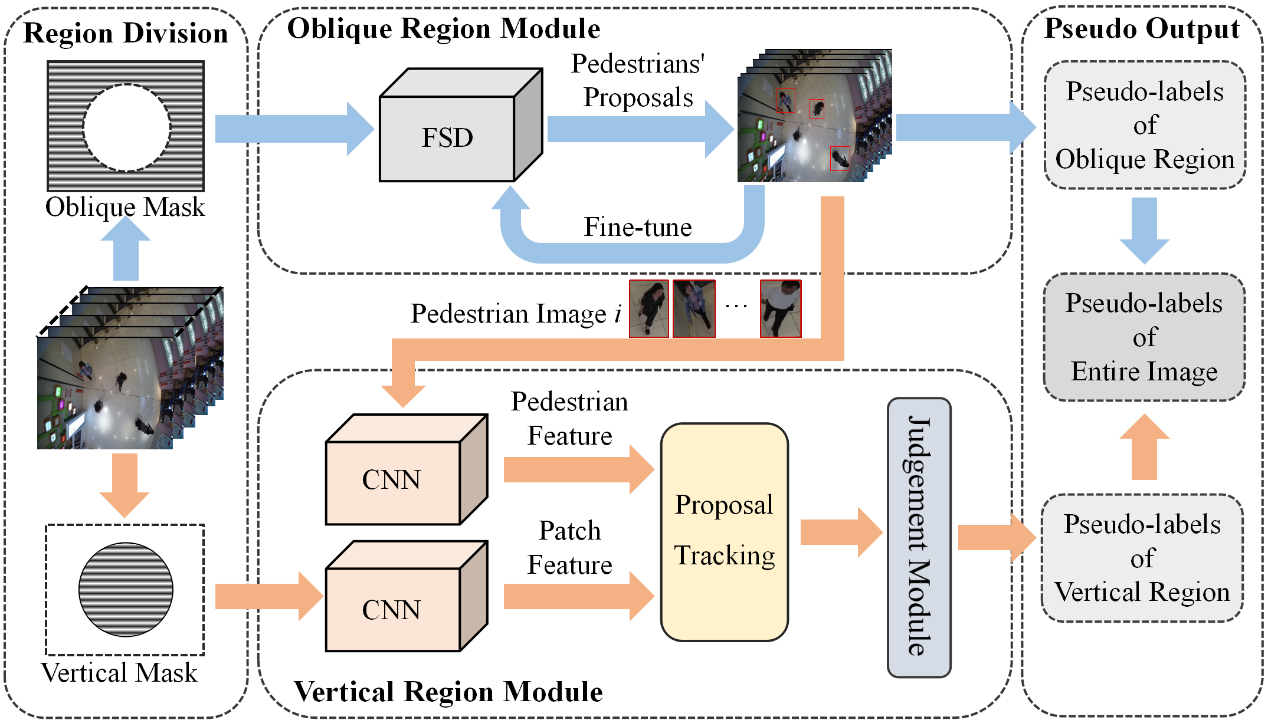

Self-Bootstrapping Pedestrian Detection in Downward-Viewing Fisheye Cameras Using Pseudo-Labeling

Kaishi Gao, Qun Niu, Haoquan You, Chengying Gao

|

|

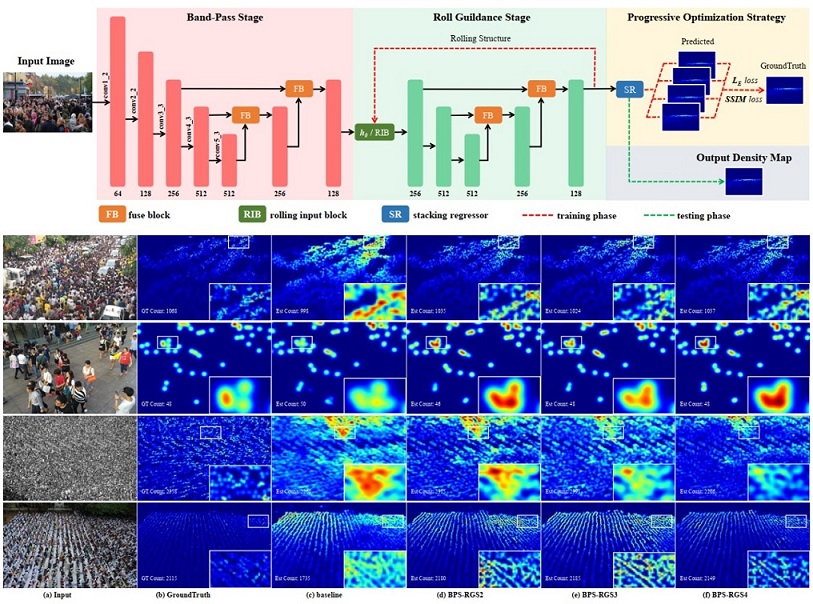

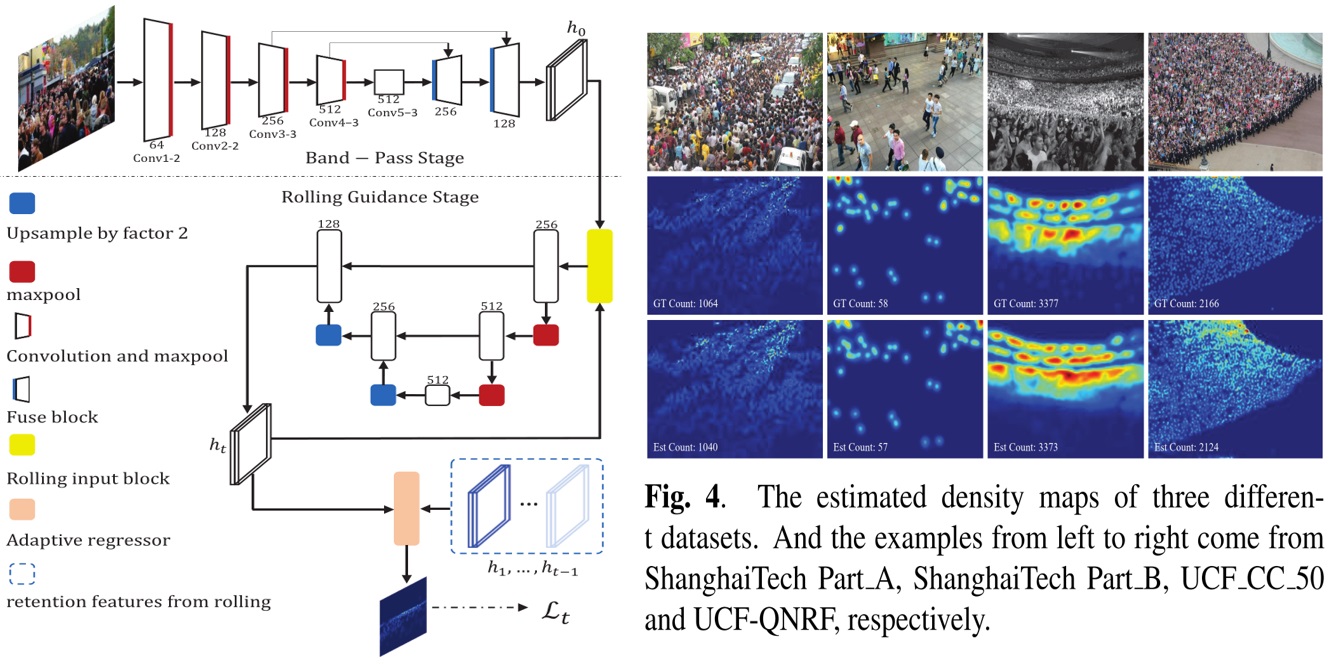

Scale-Aware Rolling Fusion Network for Crowd Counting

Ying Chen, Chengying Gao, Zhuo Su, Xiangjian He, Ning Liu

|

|

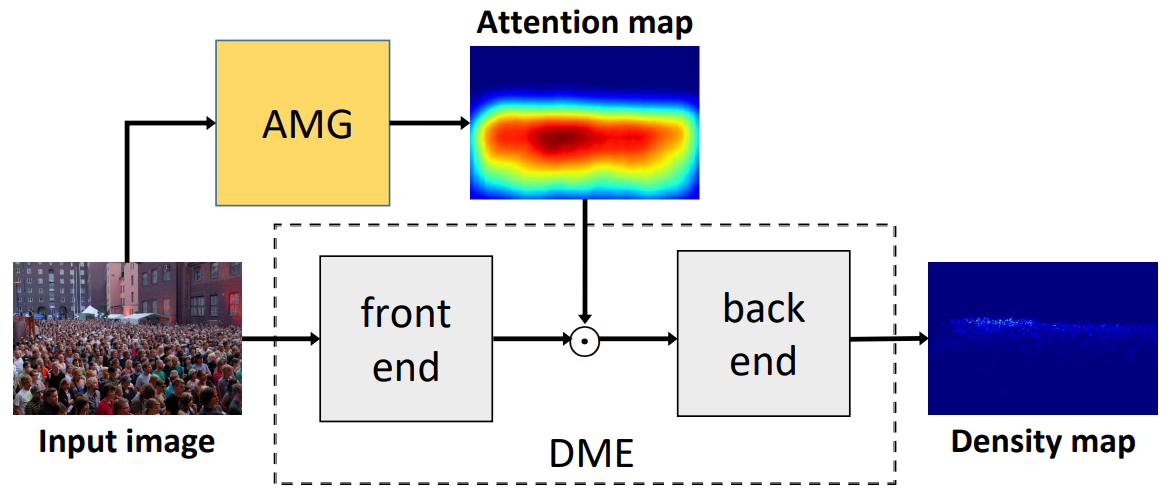

ADCrowdNet: An Attention-Injective Deformable Convolutional Network for Crowd Understanding

Ning Liu, Yongchao Long, Changqing Zou, Qun Niu, Li Pan, and Hefeng Wu

|

|

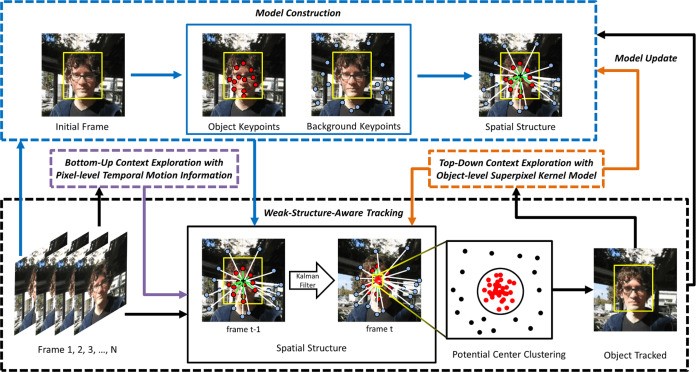

Weak-structure-aware visual object tracking with bottom-up and top-down context exploration

Liu Ning, Liu Chang, Wu Hefeng*, and Zhu Hengzheng

|